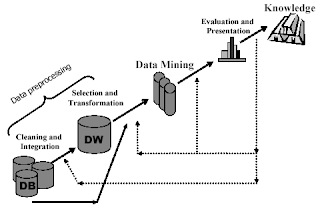

Transformasi Data dalam Tahapan Data Mining

Ada 7 (tujuh) tahapan proses data

mining, dimana 4 (empat) tahap pertama disebut juga dengan data preprocessing

(terdiri dari data cleaning, data integration, data selection,

dan data transformation), yang dalam implementasinya membutuhkan waktu sekitar

60% dari keseluruhan proses. Dalam data transformation, terdapat beberapa

pendekatan/teknik untuk melakukan transformasi data, yaitu smoothing, generalization,

normalization, aggregation, dan attribute construction.

A. Smoothing

Smoothing dilakukan jika data

mengandung noise/nilai yang tidak valid terhadap data yang di-mining. Untuk

mengatasinya harus dilakukan smoothing (dengan memperhatikan nilai-nilai

tetangga). Berikut teknik atau metode untuk smoothing:

• Binning

Metode binning dilakukan dengan

memeriksa “nilai tetangga”, yaitu nilai-nilai yang ada disekelilingnya. Berikut

adalah langkah-langkah metode binning:

1. Data diurutkan dari yang

terkecil sampai dengan yang terbesar.

2. Data yang sudah urut kemudian dipartisi ke dalam beberapa bin.

Teknik partisi ke dalam bin ada 2 (dua) cara: equal-width (distance)

partitioning dan equaldepth (frequency) partitioning.

3. Dilakukan smoothing dengan tiga macam teknik, yaitu: smoothing by

binmeans, smoothing by bin-medians, dan smoothing by

bin-boundaries.

• Clustering

Digunakan untuk menyingkirkan outliers

(keluar jauh-jauh dari cluster/centroid), data yang memiliki noise.

Algoritma k-Means yang merupakan kategori metode partitioning dapat

digunakan jika ukuran database tidak terlalu besar. Algoritma ini didasarkan

pada nilai tengah dari objek yang ada dalam cluster. Algoritma k-Means meminta

inputan parameter k, dan mempartisi satu set n objek ke dalam k

cluster sehingga menghasilkan tingkat kemiripan yang tinggi antar objek

dalam kelas yang sama (intra-class similarity) dan tingkat kemiripan

yang paling rendah antar objek dalam kelas yang berbeda (inter-class

similarity). Kemiripan cluster diukur dengan menghitung nilai tengah dari

objek yang ada di dalam cluster.

• Regression

Linear regression memodelkan sebuah random variable, Y (disebut response variable) sebagai

sebuah fungsi linier dari random variable yang lain, X (disebut sebagai predictor variable), dengan persamaan empiris: Y = α +βX , dimana α dan β adalah koefisien regresi.. Koefisien ini dapat dihitung menggunakan metode least squares dengan persamaan sebagai berikut:

Linear regression memodelkan sebuah random variable, Y (disebut response variable) sebagai

sebuah fungsi linier dari random variable yang lain, X (disebut sebagai predictor variable), dengan persamaan empiris: Y = α +βX , dimana α dan β adalah koefisien regresi.. Koefisien ini dapat dihitung menggunakan metode least squares dengan persamaan sebagai berikut:

B. Generalization

Generalization atau generalisasi

adalah ketika data level rendah (low-level data) dianti dengan konsep

yang lebih tinggi, yaitu dengan melakukan diskretisasi. Teknik diskretisasi

dapat digunakan untuk mereduksi sekumpulan nilai yang terdapat pada atribut continuous,

dengan membagi range dari atribut ke dalam interval.

Proses diskretisasi secara umum

terdiri dari 4 tahapan (gambar 2), yaitu:

1. Sorting, melakukan

sorting nilai atribut continuous yang mau didiskretisasi.

2. Memilih “cut-point”, banyak fungsi evaluasi yang dapat

digunakan seperti binning dan pengukuran entropy.

3. Splitting, dilakukan evaluasi cut-point yang ada dan pilih

satu yang terbaik dan lakukan split range nilai atribut continuous ke dalam dua

partisi. Diskretisasi berlanjut untuk tiap partisi sampai kondisi berhenti

tercapai.

4. Stopping criterion,

diperlukan untuk menghentikan proses diskretisasi.

Ada 5 metode untuk melakukan

diskretisasi pada atribut continuous, yaitu:

binning, cluster analysis, histogram

analysis, entropy-based discretization, dan segmentation by

“natural partitioning”. Dua metode pertama telah dibahas pada data smoothing,

pada subbab ini akan dibahas 3 metode yang lainnya.

• Histogram Analysis

Seperti binning sebelumnya,

pertama data harus diurutkan dahulu kemudian membagi data ke dalam keranjang

dan menyimpan nilai rata-rata (total) tiap keranjang. Untuk menentukan jumlah

keranjang dan nilai atribut yang dipartisi, ada beberapa aturan partisi yaitu: equal-width,

equal-depth, V-Optimal, dan MaxDiff. V-Optimal dan MaxDiff

histogram cenderung lebih akurat dan praktis.

Diskretisasi berdasarkan nilai

entropy merupakan metode diskretisasi secara supervised. Seperti metode

diskretisasi lainnya, atribut yang mau didiskretisasi diurutkan dahulu.

Algoritma supervised ini menggunakan class information entropy dari

partisi untuk memilih batas bin dalam melakukan diskretisasi. Jika diberikan sebuah

data set S, sebuah atribut A, dan sebuah batas partisi T, class

information entropy dari partisi dengan threshold T adalah:

adalah data yang ada pada S secara berturut-turut untuk kondisi A < T dan A ≥ T.

Fungsi entropy Ent untuk sekumpulan data yang diberikan, dihitung berdasarkan distribusi class dari data pada kumpulan tersebut. Contohnya diberikan m class, entropy dari S1 adalah:

dimana pi adalah

probabilitas class i pada S1 . Nilai dari

Ent( S2 ) dihitung dengan

cara yang sama.

Untuk atribut A, batas T min yang

meminimalkan fungsi entropy (atau memaksimalkan information gain) dari semua

batas partisi yang mungkin, dipilih sebagai batas partisi. Metode ini dapat

digunakan secara rekursif untuk kedua partisi sampai kondisi berhenti tercapai,

yaitu: Gain(A, T; S) < δ dimana δ adalah metode stopping

criterion yang mau diimplementasikan.

• Segmentation by Natural

Partitioning

- Jika sebuah interval meliputi 3, 6, 7, atau 9 distinct value pada

most significant digit (msd), maka mempartisi range tersebut ke dalam 3

interval.

- Jika sebuah interval meliputi 2, 4, atau 8 distinct value pada msd,

maka mempartisi range tersebut ke dalam 4 equal-width interval.

- Jika sebuah interval meliputi 1, 5, atau 10 distinct value pada msd,

maka mempartisi range tersebut ke dalam 5 equal-width interval.

C. Normalization

Normalization atau normalisasi

adalah proses transformasi dimana sebuah atribut numerik diskalakan dalam range

yang lebih kecil seperti -1.0 sampai 1.0, atau 0.0 sampai 1.0. Ada beberapa

metode/teknik yang diterapkan untuk normalisasi data, diantaranya:

• Min-max Normalization

Min-max

normalization memetakan sebuah value v dari atribut A menjadi v'

ke dalam range [new_minA, new_maxA] berdasarkan

• Z-Score Normalization

Disebut juga zero-mean normalization, dimana value dari sebuah atribut A dinormalisasi berdasarkan nilai rata-rata dan standar deviasi dari atribut A. Sebuah value v dari atribut A dinormalisasi menjadi v' dengan

adalah

adalah nilai rata-rata dan standar deviasi

dari atribut

nilai rata-rata dan standar deviasi

dari atribut• Normalization by Decimal Scaling

Normalisasi yang diperoleh dengan

melakukan penggeseran titik desimal dari value sebuah atribut A. Jumlah

titik desimal yang digeser tergantung dari nilai absolut maksimum dari atribut A.

D. Aggregation

Adalah operasi summary (peringkasan)

diaplikasikan pada data numerik. Misalnya pada data penjualan harian

digabungkan untuk menghitung pendapatan perbulan dan pertahun dengan

dirata-rata atau ditotal. Langkah ini dilakukan dengan memanfaatkan operator data

cube (operasi roll up/meringkas).

E. Attribute/Feature

Construction

Pada attribute construction,

atribut baru dibentuk dari atribut yang sudah ada dan ditambahkan bersama

atribut lainnya untuk membantu meningkatkan ketelitian/ketepatan dan pemahaman

struktur dalam high-dimensional data.

Contohnya, mau menambahkan atribut luas berdasarkan atribut tinggi dan lebar.

Atau, atribut lama kerja jadi dosen dan usia bisa digantikan dengan senioritas,

yunioritas, dan orientasi.

Komentar

Posting Komentar